Alicerces Teóricos: Da Lógica Booleana à Máquina Universal

5o post da série sobre a história dos computadores - Boole, Turing e Shannon

Equipe Quantum Road

Alicerces Teóricos: Da Lógica Booleana à Máquina Universal

No post anterior, conhecemos Charles Babbage e Ada Lovelace, visionários que conceberam os princípios mecânicos e algorítmicos dos computadores mais de um século antes que a tecnologia permitisse sua implementação prática. Hoje, vamos explorar outra dimensão fascinante da história dos computadores: os fundamentos teóricos e matemáticos que permitiram a transformação daquelas visões mecânicas em realidade eletrônica.

Durante o final do século XIX e a primeira metade do século XX, enquanto os avanços mecânicos em máquinas de calcular continuavam em ritmo constante, uma revolução silenciosa ocorria no campo da lógica matemática e da teoria da computação. Esta revolução estabeleceria as bases conceituais que tornariam possível a criação dos computadores eletrônicos modernos.

Este período de efervescência intelectual foi marcado por uma revolução na própria natureza da matemática. O trabalho de Gottlob Frege em lógica simbólica havia transformado o raciocínio lógico em uma linguagem matemática precisa, enquanto os Principia Mathematica de Russell e Whitehead buscavam fundamentar toda a matemática em bases lógicas rigorosas. Simultaneamente, matemáticos como David Hilbert propunham programas ambiciosos para formalizar completamente o conhecimento matemático.

Esta atmosfera de rigor formal e busca por fundamentos sólidos criou o solo fértil no qual floresceram as contribuições de Boole, Turing e Shannon. Cada um deles, à sua maneira, respondeu aos desafios conceituais de sua época: Boole matematizou a lógica, Turing definiu os limites da computação mecânica, e Shannon quantificou a própria informação. Cada um deles contribuiu com insights fundamentais que, juntos, formaram o arcabouço intelectual para a era da informação digital. Vamos explorar como suas ideias revolucionárias transformaram nossa compreensão sobre o que significa "computar" e abriram caminho para a revolução digital.

George Boole e a Álgebra Booleana

Nossa jornada pelos fundamentos teóricos da computação moderna começa com um autodidata extraordinário que transformou a lógica em uma forma de matemática.

O matemático autodidata

George Boole nasceu em 2 de novembro de 1815 em Lincoln, Inglaterra, em uma família de condições modestas. Seu pai, John Boole, era um sapateiro com interesse em matemática e ciência, mas com poucos recursos para fornecer uma educação formal adequada ao filho. Como resultado, Boole foi em grande parte autodidata, aprendendo latim e grego por conta própria, e posteriormente estudando os trabalhos de Isaac Newton e Pierre-Simon Laplace sem orientação formal.

A vida de Boole não seguiu o caminho típico dos matemáticos acadêmicos de sua época. Para ajudar a sustentar sua família após dificuldades financeiras do pai, ele começou a lecionar em escolas locais aos 16 anos. Aos 20 anos, abriu sua própria escola em Lincoln. Apesar dessas limitações, ele continuou seus estudos matemáticos independentes e começou a publicar artigos em revistas matemáticas.

Reconhecido por seu talento excepcional, mesmo sem credenciais acadêmicas formais, Boole foi nomeado professor de matemática no Queen's College em Cork, Irlanda, em 1849 – um feito notável para alguém sem formação universitária.

A matematização da lógica

Até o século XIX, a lógica era considerada principalmente um ramo da filosofia, seguindo tradições que remontavam a Aristóteles. A grande inovação de Boole foi perceber que a lógica poderia ser tratada como um sistema matemático, com suas próprias regras e operações.

Em 1847, Boole publicou "The Mathematical Analysis of Logic" (A Análise Matemática da Lógica), seguido em 1854 por sua obra mais conhecida, "An Investigation of the Laws of Thought" (Uma Investigação das Leis do Pensamento). Nestes trabalhos revolucionários, ele desenvolveu um sistema algébrico para expressar e manipular proposições lógicas utilizando símbolos matemáticos e operadores.

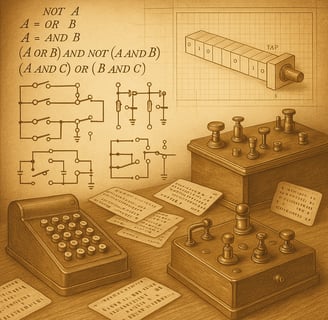

A intuição fundamental de Boole foi que o raciocínio lógico poderia ser reduzido a uma forma de cálculo, onde proposições são representadas por variáveis que podem assumir apenas dois valores: verdadeiro (representado por 1) ou falso (representado por 0). Ele então definiu operações sobre essas variáveis que correspondiam a operações lógicas básicas:

A multiplicação (x × y) correspondia à operação lógica AND (E)

A adição (x + y) correspondia à operação lógica OR (OU)

A subtração de 1 (1 - x) correspondia à operação lógica NOT (NÃO)

Com essas operações básicas, Boole mostrou que era possível representar e manipular qualquer proposição lógica através de equações algébricas, e que problemas lógicos complexos podiam ser resolvidos através de manipulações algébricas.

Do abstrato ao concreto: o caminho para os circuitos digitais

Na época em que Boole desenvolveu seu sistema, ele o considerava primariamente como uma ferramenta para o raciocínio lógico abstrato, não tendo em mente aplicações práticas em máquinas. De fato, Boole faleceu em 1864, muito antes que o potencial prático de seu trabalho fosse realizado.

A importância da álgebra booleana para a computação só seria plenamente reconhecida quase um século depois, quando Claude Shannon (que conheceremos mais adiante neste post) demonstrou, em 1937, que ela poderia ser utilizada para analisar e projetar circuitos de comutação eletrônica.

Shannon percebeu que os dois estados de um circuito elétrico – ligado (on) e desligado (off) – podiam ser mapeados perfeitamente para os valores binários 1 e 0 da álgebra booleana. As operações lógicas básicas (AND, OR, NOT) podiam ser implementadas através de arranjos específicos de relés ou, posteriormente, de válvulas e transistores.

Esta conexão fundamental entre a álgebra booleana e os circuitos eletrônicos tornou-se a base de toda a computação digital. Hoje, toda a operação interna dos computadores é governada pelos princípios da lógica booleana, desde os simples circuitos digitais até os mais complexos processadores.

Cada porta lógica em um circuito integrado, cada bit em memória, cada operação em um processador, baseia-se nos princípios da álgebra booleana. O sistema que Boole desenvolveu como uma ferramenta para o raciocínio abstrato tornou-se, assim, o alicerce concreto sobre o qual toda a infraestrutura digital moderna está construída.

Alan Turing e a Máquina de Turing

Se George Boole nos forneceu a linguagem matemática da computação, Alan Turing definiu precisamente o que significa "computar" e estabeleceu os limites fundamentais do que pode ser calculado por qualquer máquina.

O gênio de Cambridge

Alan Mathison Turing nasceu em 23 de junho de 1912 em Londres, Inglaterra. Desde jovem, demonstrou uma aptidão excepcional para a matemática e as ciências, apesar de suas outras matérias escolares serem consideradas medianas por seus professores.

Em 1931, Turing ingressou no King's College, em Cambridge, para estudar matemática. Foi lá que ele se familiarizou com os problemas fundamentais da lógica matemática que estavam agitando o campo na época, particularmente o "problema da decisão" (Entscheidungsproblem) proposto pelo matemático alemão David Hilbert.

Este problema perguntava se existe um processo mecânico definitivo (um algoritmo) que pode determinar se uma dada proposição lógica é demonstrável a partir de um conjunto de axiomas. Em essência, era uma pergunta sobre os limites da resolução mecânica de problemas matemáticos – um tema que se alinhava perfeitamente com o interesse crescente de Turing em computabilidade.

A busca por uma solução ao Entscheidungsproblem de Hilbert havia motivado alguns dos maiores matemáticos da época. Kurt Gödel havia demonstrado, em 1931, seus famosos Teoremas da Incompletude, mostrando que qualquer sistema formal suficientemente poderoso contém proposições que não podem ser provadas nem refutadas dentro do próprio sistema. Paralelamente, o matemático americano Alonzo Church desenvolveu o cálculo lambda, uma abordagem alternativa para definir computabilidade.

Quando Turing chegou a Princeton em 1936 para estudar sob orientação de Church, ele trouxe uma perspectiva única: em vez de abordar o problema apenas através da lógica matemática abstrata, ele imaginou uma máquina física capaz de realizar qualquer cálculo possível. Esta abordagem mecânica e visual do problema da computabilidade seria a chave para sua contribuição revolucionária.

O artigo que definiu a computação

Em 1936, aos 24 anos, Turing publicou seu artigo seminal "On Computable Numbers, with an Application to the Entscheidungsproblem" (Sobre Números Computáveis, com uma Aplicação ao Problema da Decisão). Neste trabalho revolucionário, Turing introduziu o conceito de uma máquina teórica – posteriormente denominada "Máquina de Turing" – capaz de implementar qualquer cálculo que pudesse ser representado por um algoritmo.

A Máquina de Turing era um dispositivo conceitual extremamente simples, consistindo de:

Uma fita infinita dividida em células, onde cada célula pode conter um símbolo de um alfabeto finito

Um cabeçote que pode ler e escrever símbolos na fita e mover-se para a esquerda ou direita

Um registro de estado que pode estar em um de um número finito de estados

Uma tabela de instruções (o "programa") que, dado o estado atual e o símbolo sob o cabeçote, especifica:

O símbolo a ser escrito na célula atual

A direção para mover o cabeçote (esquerda ou direita)

O próximo estado da máquina

Apesar de sua simplicidade conceitual, Turing demonstrou matematicamente que tal máquina poderia computar qualquer função computável – ou seja, resolver qualquer problema que pudesse ser resolvido por um algoritmo bem definido. Esta foi uma afirmação revolucionária sobre o poder da computação mecânica.

O conceito de máquina universal

Talvez a contribuição mais profunda do artigo de Turing tenha sido o conceito de "máquina universal" – uma Máquina de Turing capaz de simular qualquer outra Máquina de Turing. Em essência, Turing demonstrou que era possível construir uma única máquina programável que, com as instruções adequadas, poderia realizar qualquer cálculo computável.

Este conceito de máquina universal é a base teórica dos computadores modernos de propósito geral. A ideia de que uma única máquina, com o programa adequado, pode executar qualquer tarefa computacional, está no coração da revolução digital. Esta intuição relaciona-se diretamente com a visão de Babbage e Lovelace para a Máquina Analítica, mas Turing forneceu a formulação matemática rigorosa que provava que tal máquina era conceitualmente possível.

A equivalência entre a Máquina de Turing e outros sistemas formais de computabilidade, como o cálculo lambda de Alonzo Church, é conhecida como a Tese Church-Turing, um conceito fundamental que afirma que qualquer função que pode ser calculada por um algoritmo pode ser calculada por uma Máquina de Turing.

Limitações fundamentais: o problema da parada

Além de definir o que significa "computar", Turing também estabeleceu limites fundamentais para o que pode ser calculado. Ele demonstrou a existência de problemas que nenhum algoritmo pode resolver – os chamados "problemas indecidíveis".

O mais famoso destes é o "problema da parada" (halting problem), que pergunta se é possível determinar, para todo programa e entrada possíveis, se o programa eventualmente terminará (parará) ou continuará executando indefinidamente. Turing provou matemicamente que este problema não tem solução algorítmica.

Esta demonstração teve profundas implicações filosóficas e práticas. Filosoficamente, mostrou que existem limites intrínsecos para o que pode ser calculado mecanicamente. Praticamente, estabeleceu fronteiras fundamentais para as capacidades dos programas de computador, incluindo a impossibilidade de verificar automaticamente se um programa está livre de certos tipos de erros.

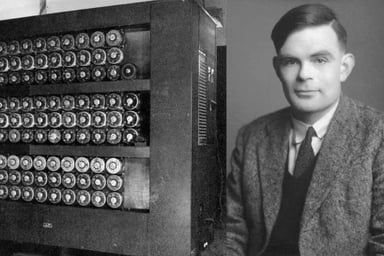

De Bletchley Park à inteligência artificial

Durante a Segunda Guerra Mundial, Turing aplicou seu brilhantismo matemático a um problema urgente e concreto: a decodificação das mensagens alemãs encriptadas pela máquina Enigma. Trabalhando em Bletchley Park, o centro britânico de criptoanálise, Turing desempenhou um papel crucial no desenvolvimento das "bombas" – máquinas eletromecânicas projetadas para descobrir as configurações diárias da Enigma.

O trabalho de Turing e sua equipe em Bletchley Park é frequentemente citado como tendo encurtado a guerra em dois a quatro anos, salvando milhões de vidas. Foi também uma das primeiras aplicações práticas em larga escala de máquinas computacionais para resolver problemas complexos do mundo real.

Após a guerra, Turing continuou suas investigações sobre computação, voltando sua atenção para o que hoje chamamos de inteligência artificial. Em seu artigo de 1950, "Computing Machinery and Intelligence" (Maquinaria Computacional e Inteligência), ele propôs o famoso "Teste de Turing" como uma forma de avaliar se uma máquina pode exibir comportamento inteligente indistinguível do de um humano.

A vida de Turing terminou tragicamente em 1954, quando ele cometeu suicídio após ser condenado por "indecência grave" devido ao seu relacionamento homossexual (que era ilegal na Grã-Bretanha naquela época) e submetido a tratamento hormonal forçado. Apenas em 2009 o governo britânico emitiu um pedido formal de desculpas pelo tratamento dado a Turing, e em 2013 ele recebeu um perdão real póstumo.

Apesar de sua morte prematura, o legado de Turing para a computação é imenso. Seu modelo teórico de computabilidade, a Máquina de Turing, continua sendo a base da ciência da computação moderna. Toda vez que programamos um computador, estamos essencialmente definindo uma Máquina de Turing específica para realizar uma tarefa particular. O conceito de uma máquina universal, programável, que pode simular qualquer outro processo computacional, é a fundação sobre a qual toda a indústria de software está construída.

Claude Shannon e a Teoria da Informação

Se Boole forneceu a linguagem matemática para a computação e Turing definiu seus limites teóricos, Claude Shannon completou o trio de gênios teóricos ao estabelecer como a informação pode ser quantificada, transmitida e processada eficientemente.

O menino que construía modelos

Claude Elwood Shannon nasceu em 30 de abril de 1916 em Petoskey, Michigan. Desde jovem, Shannon demonstrou uma curiosidade inventiva: construía modelos de aviões, montava rádios e até criou um telégrafo caseiro para se comunicar com um amigo que morava a quase um quilômetro de distância.

Shannon obteve seu bacharelado em engenharia elétrica e matemática pela Universidade de Michigan em 1936. Em seguida, ingressou no MIT para estudos de pós-graduação, onde sua dissertação de mestrado em 1937 se tornaria um dos trabalhos mais influentes na história da computação.

A conexão entre lógica booleana e circuitos elétricos

Em sua dissertação de mestrado, intitulada "A Symbolic Analysis of Relay and Switching Circuits" (Uma Análise Simbólica de Circuitos de Relés e Comutação), Shannon demonstrou como a álgebra booleana de George Boole poderia ser aplicada para analisar e projetar circuitos elétricos.

Shannon percebeu que as operações lógicas booleanas (AND, OR, NOT) podiam ser implementadas através de arranjos específicos de relés ou interruptores. Esta conexão fundamental mostrou como a lógica abstrata poderia ser codificada em hardware físico, estabelecendo a base para o projeto de circuitos digitais.

A importância desta contribuição não pode ser superestimada. Ao mostrar como a lógica booleana podia ser diretamente implementada em circuitos elétricos, Shannon estabeleceu a ponte crucial entre a matemática abstrata e a engenharia prática que tornaria possível a era dos computadores digitais.

A matemática da comunicação

Durante a Segunda Guerra Mundial, Shannon trabalhou no Bell Labs em projetos de criptografia, incluindo sistemas para proteger as comunicações telefônicas de Roosevelt e Churchill. Esta experiência, lidando com transmissão segura e eficiente de informações, influenciaria profundamente seu trabalho posterior.

Em 1948, Shannon publicou seu trabalho seminal, "A Mathematical Theory of Communication" (Uma Teoria Matemática da Comunicação), na Bell System Technical Journal. Este artigo extraordinário fundou um campo inteiramente novo: a teoria da informação.

Na teoria de Shannon, a "informação" é tratada como uma quantidade matematicamente definida, algo que pode ser medido, armazenado e transmitido. Ele introduziu o conceito de "bit" (binary digit) como a unidade básica de informação – a quantidade de informação necessária para distinguir entre duas alternativas igualmente prováveis.

Os conceitos fundamentais que Shannon desenvolveu incluíam:

Entropia: Uma medida da incerteza ou aleatoriedade em uma fonte de informação. A entropia determina a quantidade mínima de bits necessários, em média, para representar um símbolo da fonte.

Código ótimo: Shannon mostrou como construir códigos que se aproximam do limite teórico de compressão determinado pela entropia da fonte.

Capacidade de canal: Shannon definiu a taxa máxima teórica de transmissão de informação através de um canal com ruído, e provou que é possível transmitir informação com probabilidade de erro arbitrariamente pequena desde que a taxa seja menor que a capacidade do canal.

Redundância e correção de erros: Shannon demonstrou como a redundância pode ser usada para detectar e corrigir erros de transmissão, estabelecendo as bases para os códigos de correção de erros usados em todas as comunicações digitais modernas.

O impacto da teoria da informação

A teoria da informação de Shannon teve um impacto revolucionário em inúmeros campos:

Comunicações digitais: Todos os sistemas modernos de comunicação digital – de Wi-Fi a Bluetooth, de telefones celulares a internet – são projetados com base nos princípios estabelecidos por Shannon.

Compressão de dados: Algoritmos de compressão como ZIP, JPEG e MP3 derivam dos insights de Shannon sobre codificação eficiente.

Criptografia: A teoria da informação fornece os fundamentos matemáticos para a criptografia moderna.

Linguística e processamento de linguagem natural: Os conceitos de Shannon, como entropia e redundância, são aplicados na análise estatística de linguagens naturais e no design de sistemas de processamento de linguagem.

Inteligência artificial e aprendizado de máquina: Muitos algoritmos de aprendizado de máquina utilizam medidas baseadas em teoria da informação para quantificar similaridades e diferenças entre dados.

Além de suas contribuições à teoria da informação, Shannon também foi um pioneiro em áreas como inteligência artificial e teoria dos jogos aplicada. Ele construiu uma das primeiras máquinas de xadrez por computador e criou o "Rato Theseus", um dos primeiros exemplos de máquina de aprendizado.

Shannon combinou brilhantismo teórico com criatividade prática de maneiras que definiram os rumos da tecnologia da informação por gerações. Sua visão da informação como uma quantidade mensurável, independente de seu significado específico, forneceu a base conceitual que permitiu a digitalização de todos os tipos de dados – texto, imagens, áudio, vídeo – e sua manipulação uniforme por computadores digitais.

As vidas e trabalhos de Boole, Turing e Shannon se entrelaçaram de maneiras fascinantes. Shannon descobriu o trabalho de Boole durante uma aula de filosofia na Universidade de Michigan em 1932, percebendo imediatamente sua aplicabilidade aos circuitos elétricos. Posteriormente, durante a Segunda Guerra Mundial, Shannon e Turing se encontraram nos Bell Labs em 1943, onde ambos trabalhavam em projetos de criptografia. Suas conversas sobre máquinas inteligentes e processamento de informação foram visionárias, antecipando em décadas desenvolvimentos em inteligência artificial.

Turing chegou a consultar Shannon sobre seu interesse em construir um "cérebro eletrônico", enquanto Shannon compartilhou suas ideias sobre quantificação da informação. Este encontro de mentes brilhantes ilustra como os avanços científicos frequentemente emergem da convergência de diferentes perspectivas sobre problemas fundamentais.

A fusão de teoria e prática

Enquanto Boole, Turing e Shannon estabeleciam os fundamentos teóricos, importantes desenvolvimentos paralelos ocorriam no campo das máquinas de calcular. A Máquina Analítica de Charles Babbage, concebida em 1837, já antecipava muitos princípios dos computadores modernos, incluindo uma unidade central de processamento e memória programável. No final do século XIX, Herman Hollerith desenvolveu o sistema de cartões perfurados para processar dados do censo americano, estabelecendo os primeiros métodos de processamento automático de informações em larga escala.

Estes avanços mecânicos e eletromecânicos criaram o contexto prático necessário para que as abstrações teóricas de nossos três protagonistas encontrassem aplicação no mundo real. A convergência entre teoria matemática e engenharia mecânica preparava o terreno para a revolução eletrônica que estava por vir.

As contribuições teóricas de Boole, Turing e Shannon estabeleceram o arcabouço conceitual da computação moderna. Cada um deles iluminou uma dimensão essencial da computação:

Boole: A linguagem lógica da computação (álgebra booleana)

Turing: Os limites e possibilidades da computação (teoria da computabilidade)

Shannon: A quantificação e manipulação da informação (teoria da informação)

Juntas, estas teorias forneceram os fundamentos sobre os quais os engenheiros poderiam construir máquinas computacionais práticas. A conexão entre a matemática abstrata e a engenharia concreta foi fortalecida durante e após a Segunda Guerra Mundial, quando a necessidade urgente de cálculos complexos para fins militares estimulou o desenvolvimento rápido de computadores eletrônicos.

Os primeiros computadores eletrônicos, como o ENIAC e o EDVAC (que exploraremos em posts futuros), incorporaram diretamente os princípios teóricos desenvolvidos por estes pioneiros. Os circuitos digitais do ENIAC implementavam operações booleanas; o conceito de programa armazenado no EDVAC derivava diretamente da noção de máquina universal de Turing; e os sistemas de codificação e armazenamento de informação refletiam os insights da teoria da informação de Shannon.

Lições para a era digital

As histórias de Boole, Turing e Shannon oferecem lições valiosas para nossa compreensão da tecnologia contemporânea:

O poder das abstrações matemáticas

O trabalho destes três pensadores demonstra como abstrações matemáticas aparentemente distantes de aplicações práticas podem, eventualmente, transformar o mundo material. A álgebra booleana, a Máquina de Turing e a teoria da informação começaram como construções teóricas abstratas, mas acabaram se tornando os fundamentos da revolução digital.

A importância da interdisciplinaridade

Cada um destes pioneiros cruzou fronteiras disciplinares tradicionais: Boole conectou lógica e álgebra; Turing uniu matemática, lógica e o conceito de computação mecânica; Shannon vinculou teoria da comunicação, eletrônica e probabilidade. Seus avanços mais significativos ocorreram precisamente nestas interseções entre diferentes campos do conhecimento.

O longo caminho da teoria à aplicação

Décadas se passaram entre as descobertas teóricas destes pensadores e a plena realização de suas implicações práticas. A álgebra booleana de 1854 só encontrou sua aplicação em circuitos eletrônicos na década de 1930. A máquina universal de Turing de 1936 só começou a ser implementada concretamente na década de 1940. Esta perspectiva histórica nos lembra que as sementes conceituais plantadas hoje podem levar gerações para florescer completamente em aplicações práticas.

A dualidade hardware-software

As teorias desenvolvidas por estes pioneiros ajudaram a cristalizar a distinção fundamental entre hardware (a máquina física) e software (as instruções que a controlam) – uma distinção que está no coração da flexibilidade e poder da computação moderna. Esta dualidade, implícita na máquina universal de Turing e reforçada pela teoria da informação de Shannon, permite que o mesmo hardware execute uma infinidade de tarefas diferentes dependendo apenas do software.

O que vem a seguir?

No próximo post de nossa série, exploraremos como John von Neumann sintetizou estas bases teóricas em uma arquitetura prática para computadores que continua a influenciar o design de computadores até hoje. Veremos como este brilhante matemático e físico húngaro-americano formalizou a estrutura do computador com programa armazenado – a chamada "arquitetura de von Neumann" – que se tornaria o modelo dominante para computadores digitais por gerações.

Prepare-se para descobrir como as abstrações teóricas que exploramos hoje se transformaram em blueprints concretos para máquinas que mudariam o mundo!

Equipe Quantum Road

30/04/2025

Imagens e Ilustrações

Allan Touring e a Máquina de Touring (1936)

Referências

[1] G. Boole, "An Investigation of the Laws of Thought", Dover Publications, 1958 (originalmente publicado em 1854).

[2] A. M. Turing, "On Computable Numbers, with an Application to the Entscheidungsproblem", Proceedings of the London Mathematical Society, 1937.

[3] C. E. Shannon, "A Mathematical Theory of Communication", Bell System Technical Journal, 1948.

[4] I. J. Good, "A. M. Turing's Statistical Work in World War II", Biometrika, 1979.

[5] M. Davis, "The Universal Computer: The Road from Leibniz to Turing", W. W. Norton & Company, 2000.

[6] J. Gleick, "The Information: A History, a Theory, a Flood", Pantheon Books, 2011.

[7] A. Hodges, "Alan Turing: The Enigma", Princeton University Press, 2014.

[8] N. Wiener, "Cybernetics: Or Control and Communication in the Animal and the Machine", MIT Press, 1948.

[9] C. Petzold, "Code: The Hidden Language of Computer Hardware and Software", Microsoft Press, 2000.